Spark 对接 Alluxio

1、概览

Spark 1.1 或更高版本的 Spark可以通过其与 HDFS 兼容的接口直接访问 Alluxio 集群。 使用 Alluxio 作为数据访问层,Spark 应用程序可以透明地访问许多不同类型的持久化存储服务(例如,AWS S3 bucket、Azure Object Store buckets、远程部署的 HDFS 等)的数据,也可以透明地访问同一类型持久化存储服务不同实例中的数据。 为了加快 I/O 性能,用户可以主动获取数据到 Alluxio 中或将数据透明地缓存到 Alluxio 中。 此外,通过将计算和物理存储解耦,Alluxio 能够有助于简化系统架构。 当底层持久化存储中真实数据的路径对 Spark 隐藏时,对底层存储的更改可以独立于应用程序逻辑;同时,Alluxio 作为邻近计算的缓存,仍然可以给计算框架提供类似 Spark 数据本地性的特性。

2、基础设置

将 Alluxio客户端 jar 包分发在运行 Spark driver 或 executor 的节点上。具体地说,将客户端 jar 包放在每个节点上的同一本地路径(例如/<PATH_TO_ALLUXIO>/client/alluxio-2.9.3-client.jar)。

或将 Alluxio 客户端 jar 包添加到 Spark driver 和 executor 的 classpath 中,以便 Spark 应用程序能够使用客户端 jar 包在 Alluxio 中读取和写入文件。具体来说,在运行 Spark 的每个节点上,将以下几行添加到 spark/conf/spark-defaults.conf 中。

spark.driver.extraClassPath /<PATH_TO_ALLUXIO>/client/alluxio-2.9.3-client.jar spark.executor.extraClassPath /<PATH_TO_ALLUXIO>/client/alluxio-2.9.3-client.jar

3、示例:使用 Alluxio 作为输入和输出

3.1、访问仅在Alluxio中的数据

将本地数据复制到 Alluxio 文件系统中。 假设你在 Alluxio 项目目录中,将LICENSE文件放入 Alluxio,运行:

$ ./bin/alluxio fs copyFromLocal LICENSE /Input

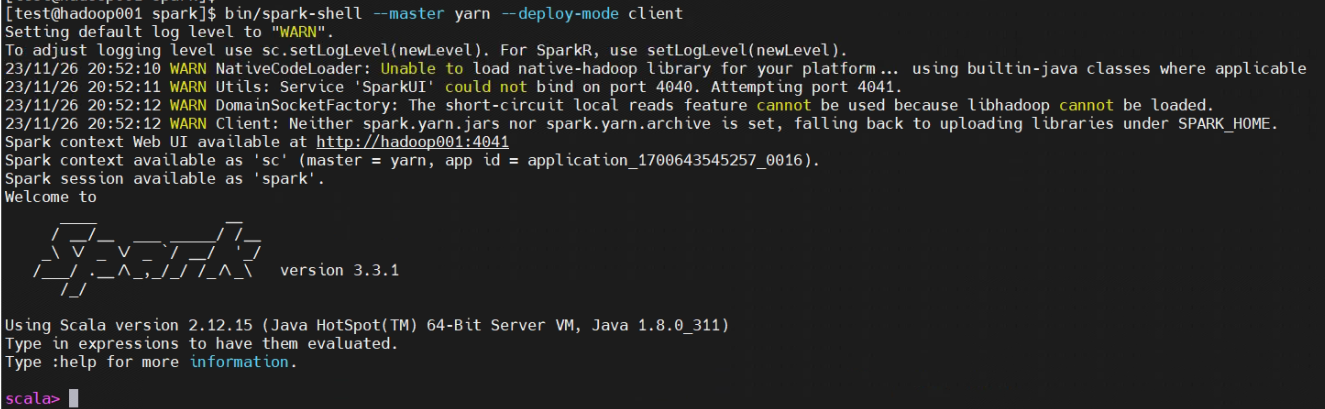

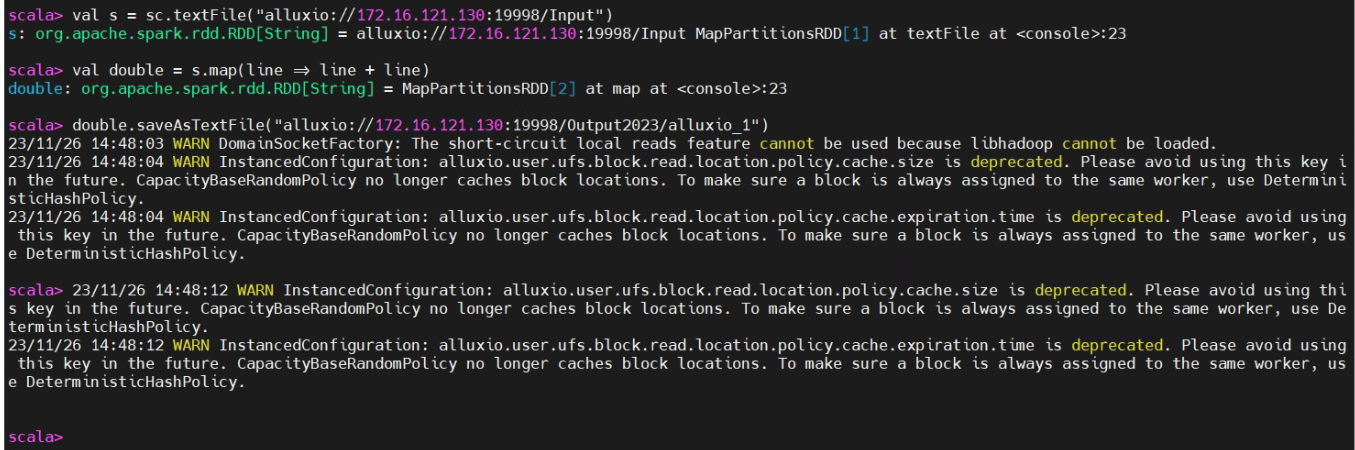

假设 Alluxio Master 运行在localhost上,在spark-shell中运行如下命令:

> val s = sc.textFile("alluxio://localhost:19998/Input")

> val double = s.map(line => line + line)

> double.saveAsTextFile("alluxio://localhost:19998/Output")打开浏览器,查看 http://localhost:19999/browse。 应该存在一个输出目录/Output,其中包含了输入文件Input的双倍内容

3.2、访问底层存储中的数据

给出准确路径后,Alluxio 支持透明地从底层存储系统中获取数据。 在本节中,使用 HDFS 作为分布式存储系统的示例。

将测试文件放入到 HDFS 中:

hdfs dfs -put sparktest /

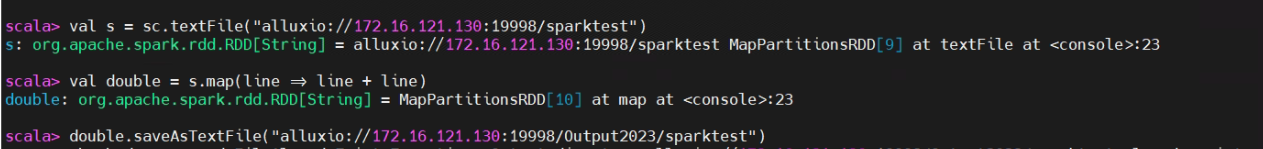

请注意,Alluxio 并不知道该文件。你可以通过访问 Web UI 来验证这一点。 假设 Alluxio Master 运行在localhost上,在spark-shell中运行如下命令:

val s = sc.textFile("alluxio://172.16.121.130:19998/sparktest")

val double = s.map(line => line + line)

double.saveAsTextFile("alluxio://172.16.121.130:19998/Output2023/sparktest")打开浏览器,查看 http://localhost:19999/browse。