高效安全迁移:PG高可用集群实战方案深度解析

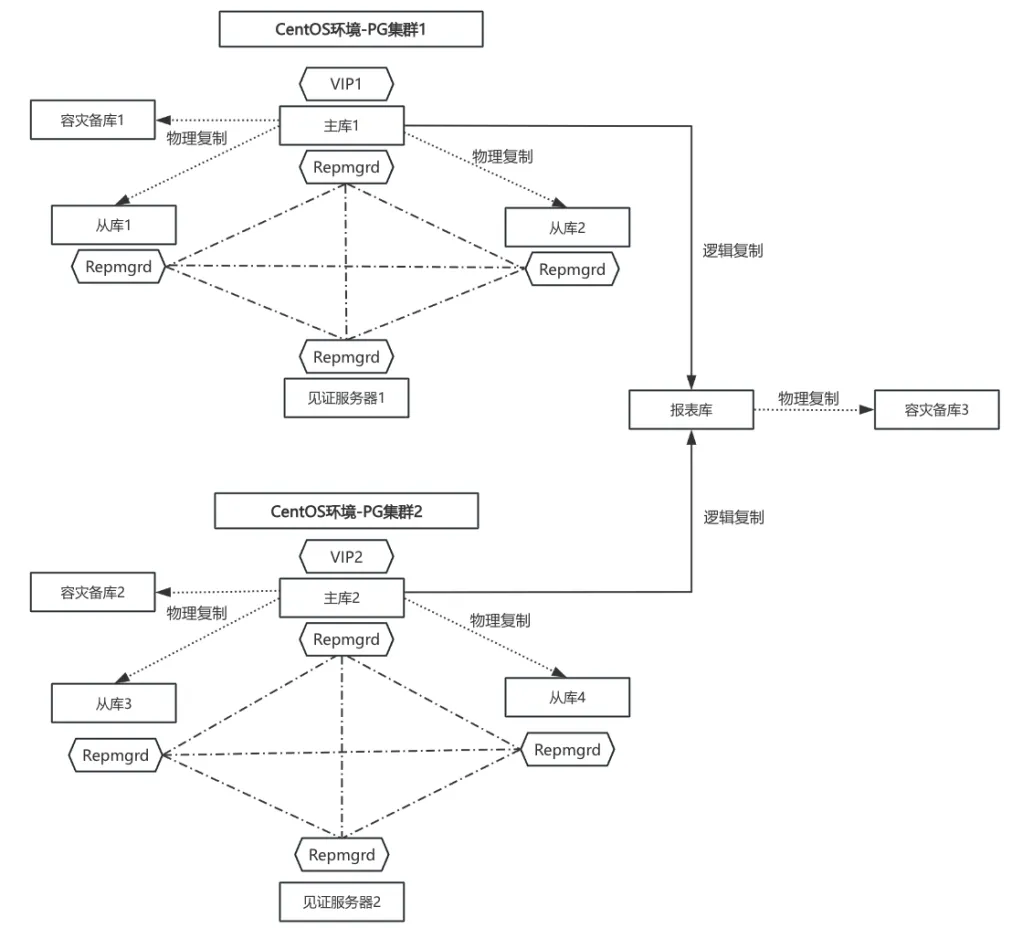

方案一

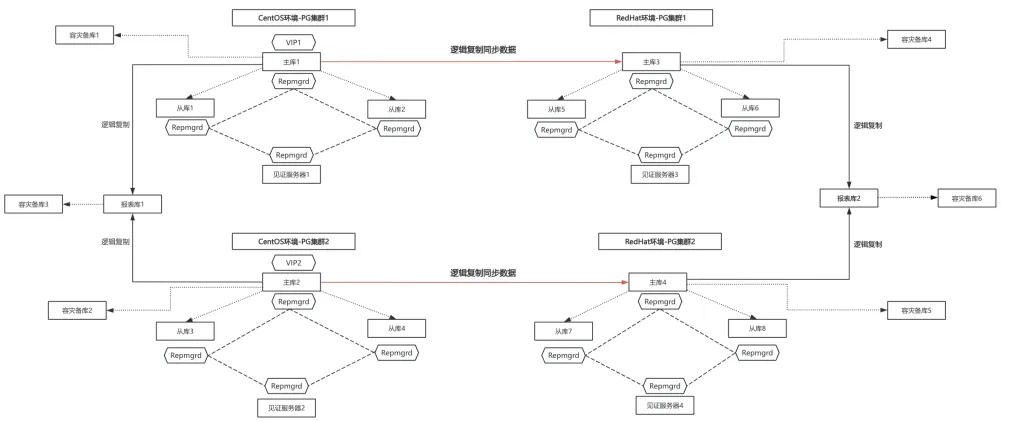

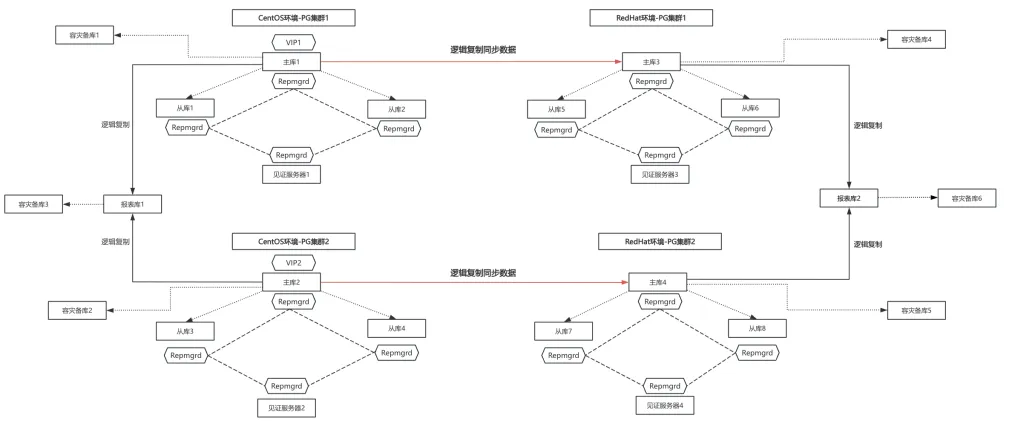

方案二

两种方案优缺点对比

方案二CentOS环境与RedHat环境之间PG的数据同步性比较差通过逻辑复制实现,逻辑复制操作麻烦、有很多限制,比如表必须都有主键、每个库都需要创建一个逻辑复制同步通道,逻辑复制的同步能力和稳定,可能出现同步状态异常或出现较大延迟。另外逻辑复制只同步数据,需用插件同步DDL语句,还需通过备份将CentOS环境的账号权限、视图等对象定义恢复至RedHat环境。该方法的优点是RedHat环境报表库的数据一开始就可以同步,报表库不可用的时间很短。

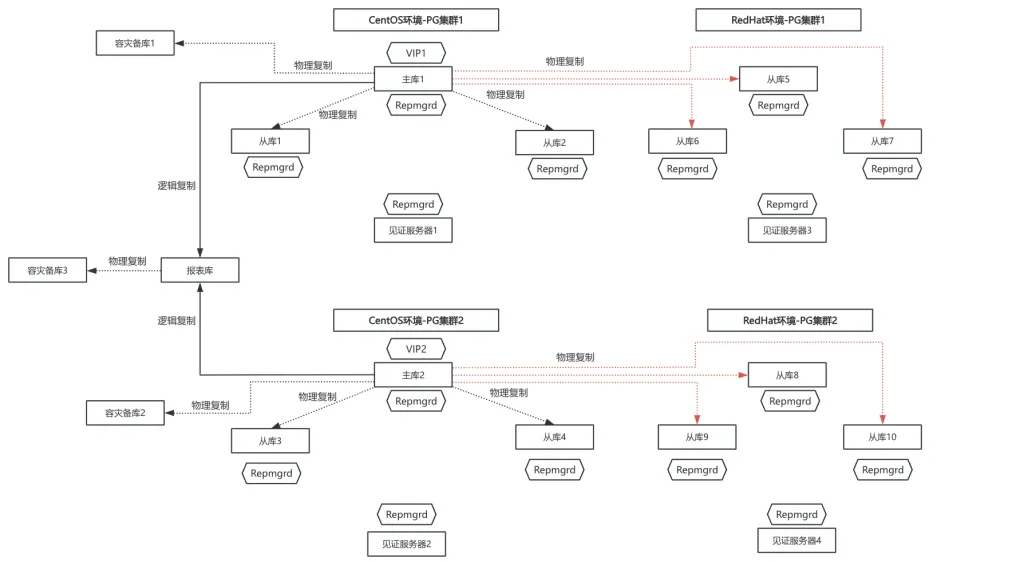

确定操作方案

具体操作步骤

一、RedHat环境准备工作

RedHat环境搭建PG、REPMGR,其中见证节点初始化PG,从节点采用REPMGR进行数据克隆、物理复制同步,记录数据克隆耗时及对当前主库的性能消耗影响。

将RedHat环境部署的从节点和见证节点的PG,加入至当前主库所在的REPMGR集群。

RedHat环境安装pg_probackup,用于WAL日志归档及备份任务设置。

RedHat环境新报表库初始化PG。

二、RedHat环境新报表库同步测试

梳理报表库数据信息

CentOS环境,当前报表库的数据分为3部分,第1部分由PG集群1的主库逻辑复制同步而来,第2部分由PG集群2的主库逻辑复制同步而来,第3部分是业务自身在报表库新增的schema。

对于RedHat环境的新报表库,第1、2部分的数据需待主库切换后由新主通过逻辑复制同步至新报表库,第3部分需要通过pg_dump将相关schema数据备份恢复至新报表库。

备份恢复测试

针对业务自身在报表库新增的schema,需通过pg_dump备份的方式将数据恢复至新报表库,测试该部分数据备份恢复的耗时情况及期间的性能消耗情况。

备份恢复的方式是先用pg_dumpall将当前报表库所有对象结构进行备份再用pg_dump对相关schema的数据进行备份,相关命令如下:

--备份所有对象结构

pg_dumpall -s -U{user_name} -p{port} -f "/xxx/all_object.sql"

--备份指定schema数据

pg_dump -Fd -v -a -U{user_name} -p{port} -d{db_name} -n{schema_name} -j2 -f "/xxx/{schema_name}.dump"

--恢复所有对象结构

psql -U{user_name} -p{port} -d{db_name} -f /xxx/all_object.sql >> /xxx/all_object.log 2>&1

--恢复指定schema数据

pg_restore -p{port} -d{db_name} -U{user_name} -j2 /xxx/schema_name.dump >> /xxx/{schema_name}.log 2>&1

逻辑复制同步测试

针对由PG集群1、2的主库逻辑复制同步至报表库的数据,将RedHat环境从库5、从库8作为单独新主启动,测试新主逻辑同步至新报表库所需耗时及期间的性能消耗情况。

RedHat环境从库5、从库8数据同步完成后,单独作为新主启动,作为测试逻辑复制同步的源端:

--操作步骤如下

a.stop PG;

b.修改postgres.auto.conf,注释掉synchronous_standby_names、primary_conninfo、primary_slot_name;

c.删掉pg data目录下的standby.signal文件;

d.start PG

创建RedHat环境新主至新报表库的逻辑复制同步任务:

--新报表库部分命令如下

create subscription {sub_name} connection 'host={master_ip} port={port} dbname={db_name} user={user_name} password={password}' publication {pub_name};

alter subscription {sub_name} refresh publication ;

RedHat新主库与新报表库安装pgl_ddl_deploy插件:

--新主库部分命令如下

CREATE EXTENSION pgl_ddl_deploy;

INSERT INTO pgl_ddl_deploy.set_configs (set_name,include_schema_regex,driver) VALUES('{pub_name}','{schema_name}','native'::pgl_ddl_deploy.driver);

SELECT pgl_ddl_deploy.deploy('{pub_name}') from pgl_ddl_deploy.set_configs;

SELECT pgl_ddl_deploy.add_role(oid) from pg_roles where rolname='{user_name}';

select * from pgl_ddl_deploy.set_configs;

--新报表库部分命令如下

CREATE EXTENSION pgl_ddl_deploy;

SELECT pgl_ddl_deploy.add_role(oid) from pg_roles where rolname='{user_name}';

alter subscription {sub_name} refresh publication;

三、正式切换整体步骤

准备好RedHat环境,清理新报表库测试时的相关环境,令其满足切换条件,包括RedHat环境PG与REPMGR搭建完成、从库数据同步完成、新报表库初始化完成。

因后续RedHat环境与CentOS环境IP需互换,IP更换后PG在REPMGR集群中需重新注册,提前注销REPMGR集群中的从节点、见证节点。

关闭业务。

关闭PG及监控,先关主库,后关从节点、见证节点、报表库、容灾备库,最后停监控告警。

整体替换IP,将CentOS环境与RedHat环境的IP进行替换。

修改REPMGR与PG相关配置文件中与IP有关的相关内容。

启动PG,先启主库,后启从节点、见证节点、报表库。

将主节点、从节点、见证节点重新注册至REPMGR集群。

切主,将主节点由CentOS环境的主库切至RedHat环境的其中一个从库,切换后VIP会绑定新主。

将切换后的旧主作为新主的从节点,重新加入REPMGR集群。

开启监控告警。

开始处理RedHat环境新报表库,将CentOS环境报表库自身产生的数据通过备份恢复至RedHat环境新报表库,将需同步的数据由RedHat环境新主库逻辑复制同步至新报表库。

设置WAL归档与备份任务,确认复制同步状态及延迟情况,核对同步对象数量、表数据量是否一致。

开启业务,确认业务是否正常。

总结

通过两种不同的迁移方案,均可实现PG高可用集群的迁移切换,便于结合业务需求使用更为稳定的物理复制同步方案,使客户的PG集群整体平稳迁至新环境。

云掣专注于可观测运维,致力解决企业上云难、用云难、管云难三大问题。基于云数据库提供7*24小时保障服务,提供开发支持、数据库体系规范、持续优化、数据库架构支持,保障企业数据库高效稳定运行。全面提升企业的运维效率和稳定性,助力企业完成云时代的数字化转型,满足客户在数据库管理和云迁移方面的多样化需求!

云掣基于多年在运维领域的丰富时间经验,编写了《云运维服务白皮书》,欢迎大家互相交流学习:

《云运维服务白皮书》下载地址:https://fs80.cn/v2kbbq

想了解更多大数据运维托管服务、数据库运维托管服务、应用系统运维托管服务的的客户,欢迎点击云掣官网沟通咨询:https://yunche.pro/?t=shequ