clickhouse集群对接hive(三)

前提:集群中已经部署了hive组件和clickhouse集群,clickhouse集群进行对接hive

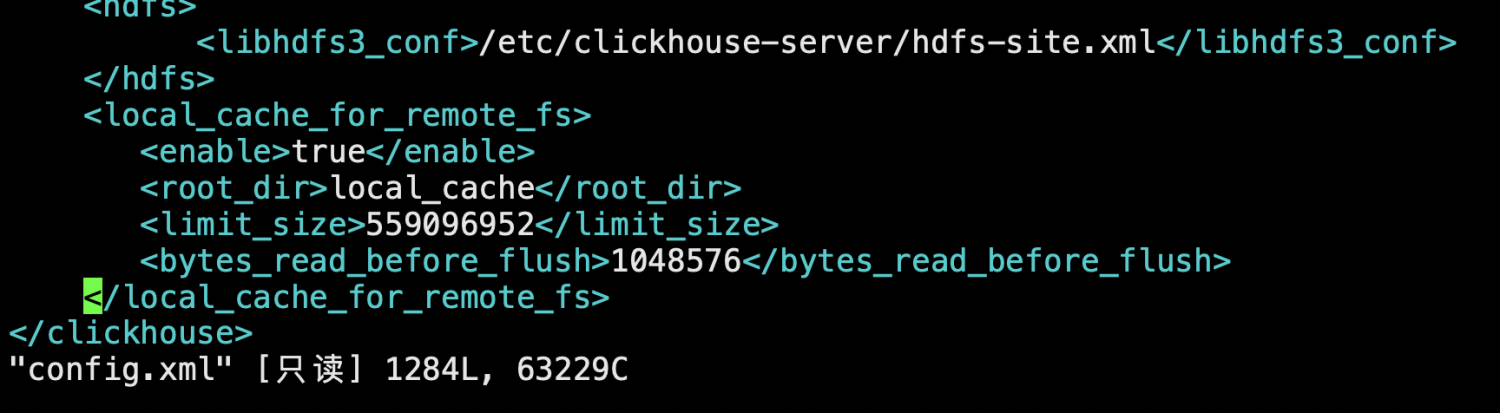

1、设置hdfs文件系统本地缓存

<local_cache_for_remote_fs> <enable>true</enable> <root_dir>local_cache</root_dir> <limit_size>559096952</limit_size> <bytes_read_before_flush>1048576</bytes_read_before_flush> </local_cache_for_remote_fs>

2、在hive中创建orc的表

user use test;

CREATE TABLE `test`.`test_orc`(

`f_tinyint` tinyint,

`f_smallint` smallint,

`f_int` int,

`f_integer` int,

`f_bigint` bigint,

`f_float` float,

`f_double` double,

`f_decimal` decimal(10,0),

`f_timestamp` timestamp,

`f_date` date,

`f_string` string,

`f_varchar` String,

`f_bool` boolean,

`f_binary` binary,

`f_array_int` array<int>,

`f_array_string` array<string>,

`f_array_float` array<float>,

`f_array_array_int` array<array<int>>,

`f_array_array_string` array<array<string>>,

`f_array_array_float` array<array<float>>)

PARTITIONED BY (

`day` string)

ROW FORMAT SERDE

'org.apache.hadoop.hive.ql.io.orc.OrcSerde'

STORED AS INPUTFORMAT

'org.apache.hadoop.hive.ql.io.orc.OrcInputFormat'

OUTPUTFORMAT

'org.apache.hadoop.hive.ql.io.orc.OrcOutputFormat'

LOCATION

'hdfs://mycluster/user/hive/warehouse/test.db/test_orc';

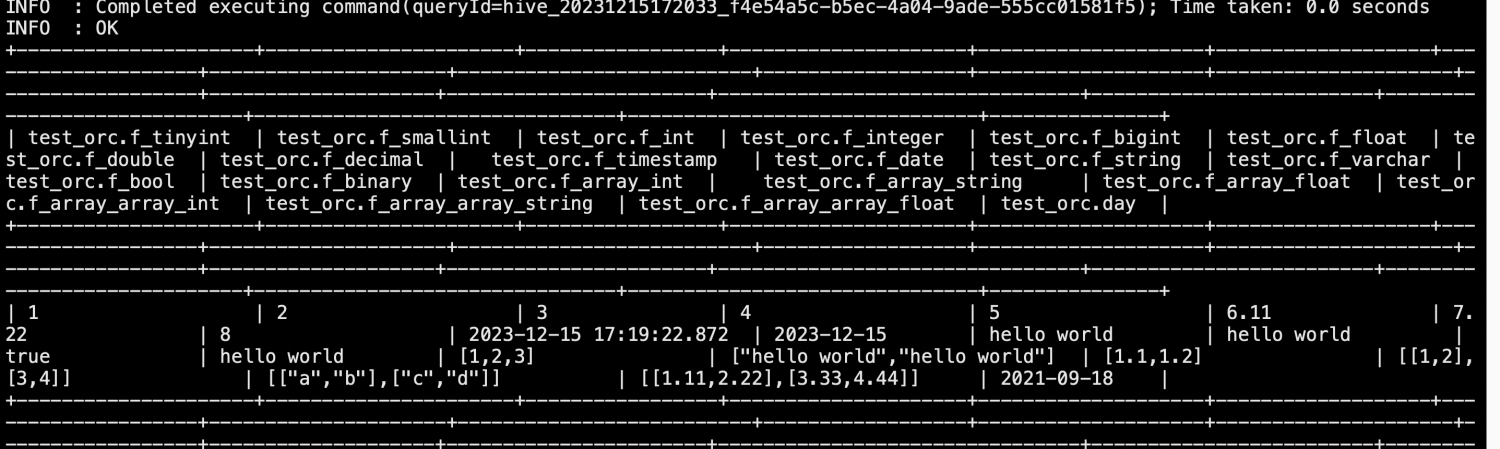

insert into test.test_orc partition(day='2021-09-18') select 1, 2, 3, 4, 5, 6.11, 7.22, 8.333, current_timestamp(), current_date(),'hello world', 'hello world', true, 'hello world', array(1, 2, 3), array('hello world', 'hello world'), array(float(1.1), float(1.2)), array(array(1, 2), array(3, 4)), array(array('a', 'b'), array('c', 'd')), array(array(float(1.11), float(2.22)), array(float(3.33), float(4.44)));

在clickhouse中创建表

CREATE TABLE test.test_orc

(

`f_tinyint` Int8,

`f_smallint` Int16,

`f_int` Int32,

`f_integer` Int32,

`f_bigint` Int64,

`f_float` Float32,

`f_double` Float64,

`f_decimal` Float64,

`f_timestamp` DateTime,

`f_date` Date,

`f_string` String,

`f_varchar` String,

`f_bool` Bool,

`f_binary` String,

`f_array_int` Array(Int32),

`f_array_string` Array(String),

`f_array_float` Array(Float32),

`f_array_array_int` Array(Array(Int32)),

`f_array_array_string` Array(Array(String)),

`f_array_array_float` Array(Array(Float32)),

`day` String

)

ENGINE = Hive('thrift://172.16.121.0:9083', 'test', 'test_orc')

PARTITION BY day

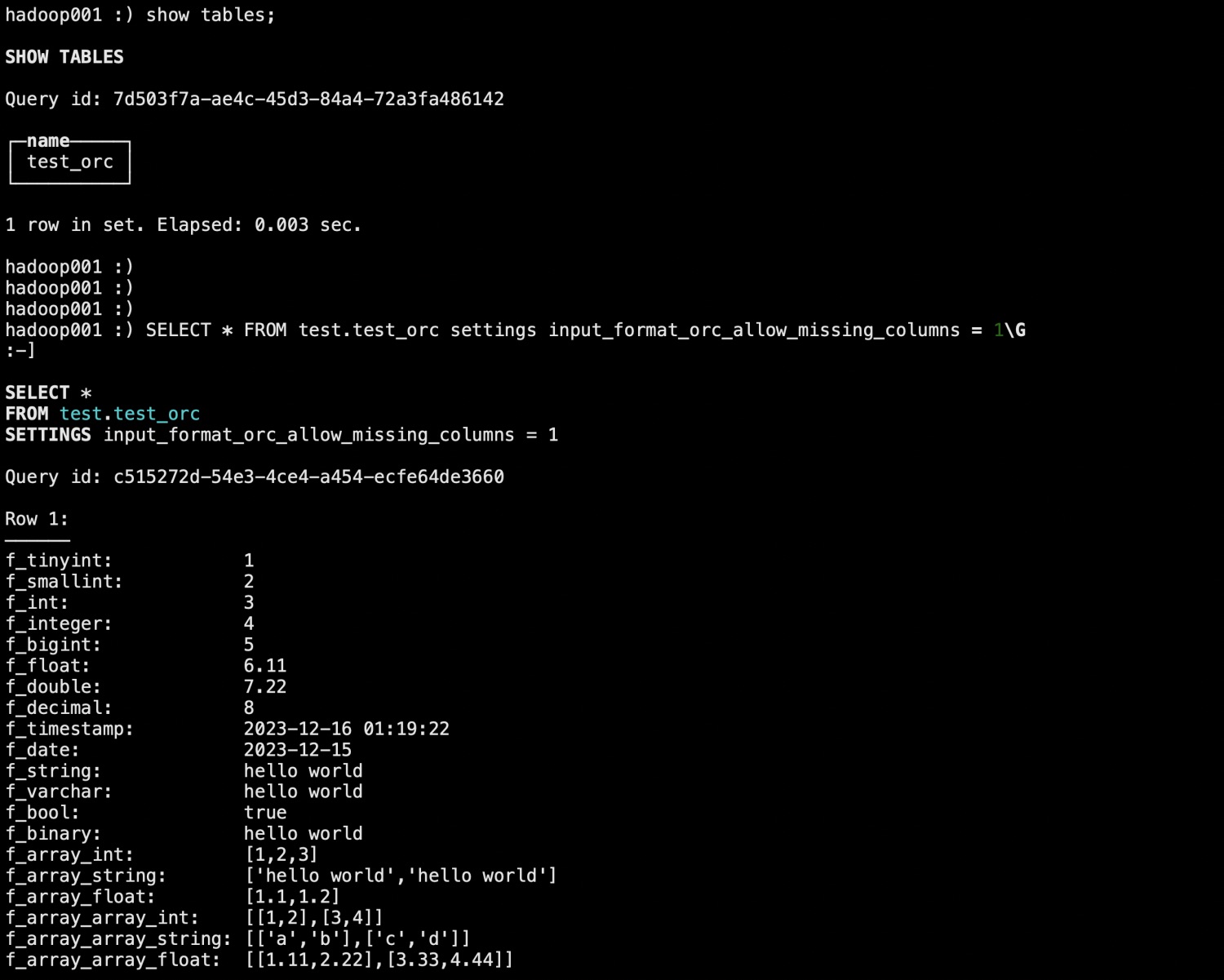

SELECT * FROM test.test_orc settings input_format_orc_allow_missing_columns = 1\G