大数据集群部署规划(一)关于节点的定义

节点定义:

CDH集群节点定义

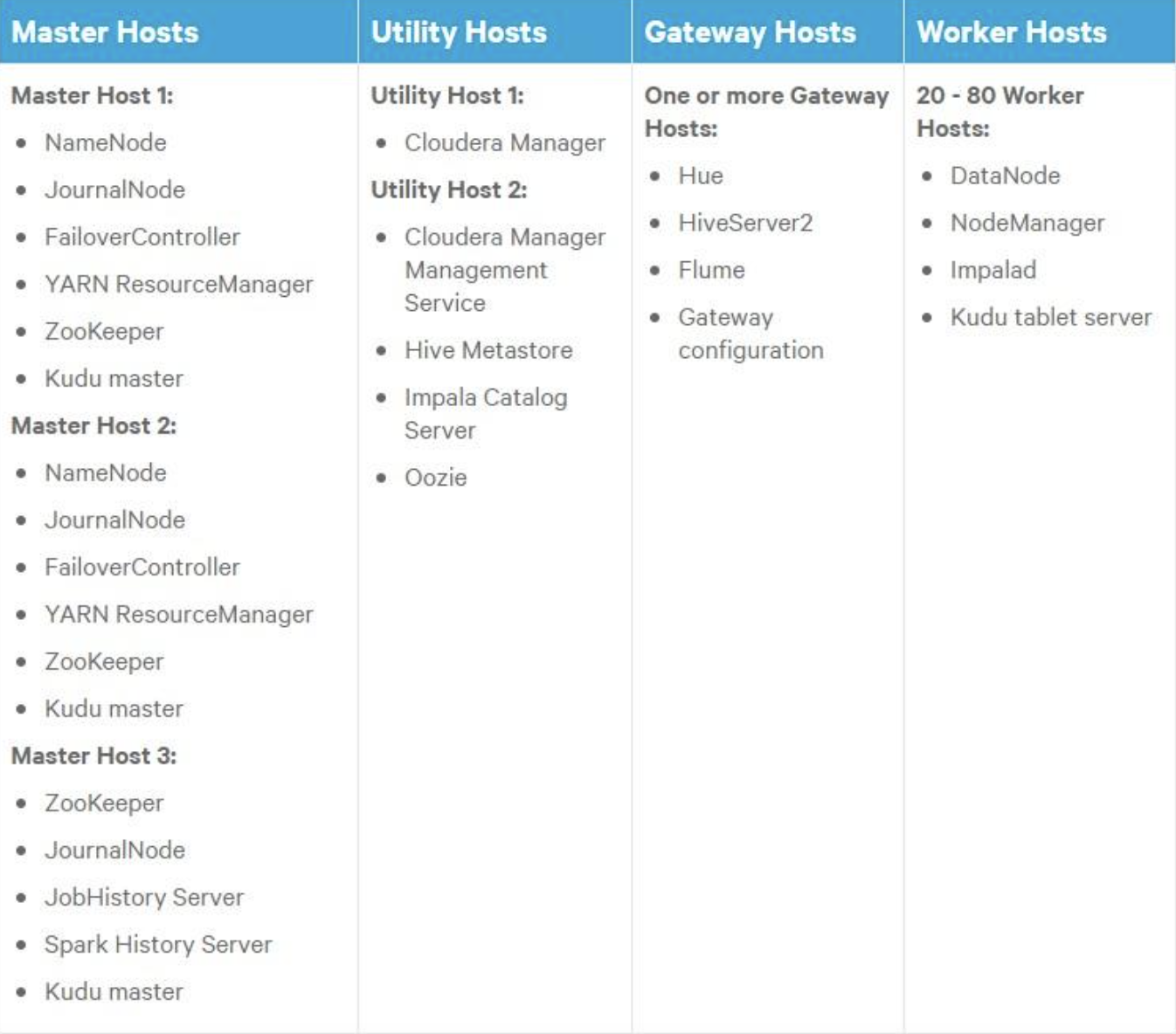

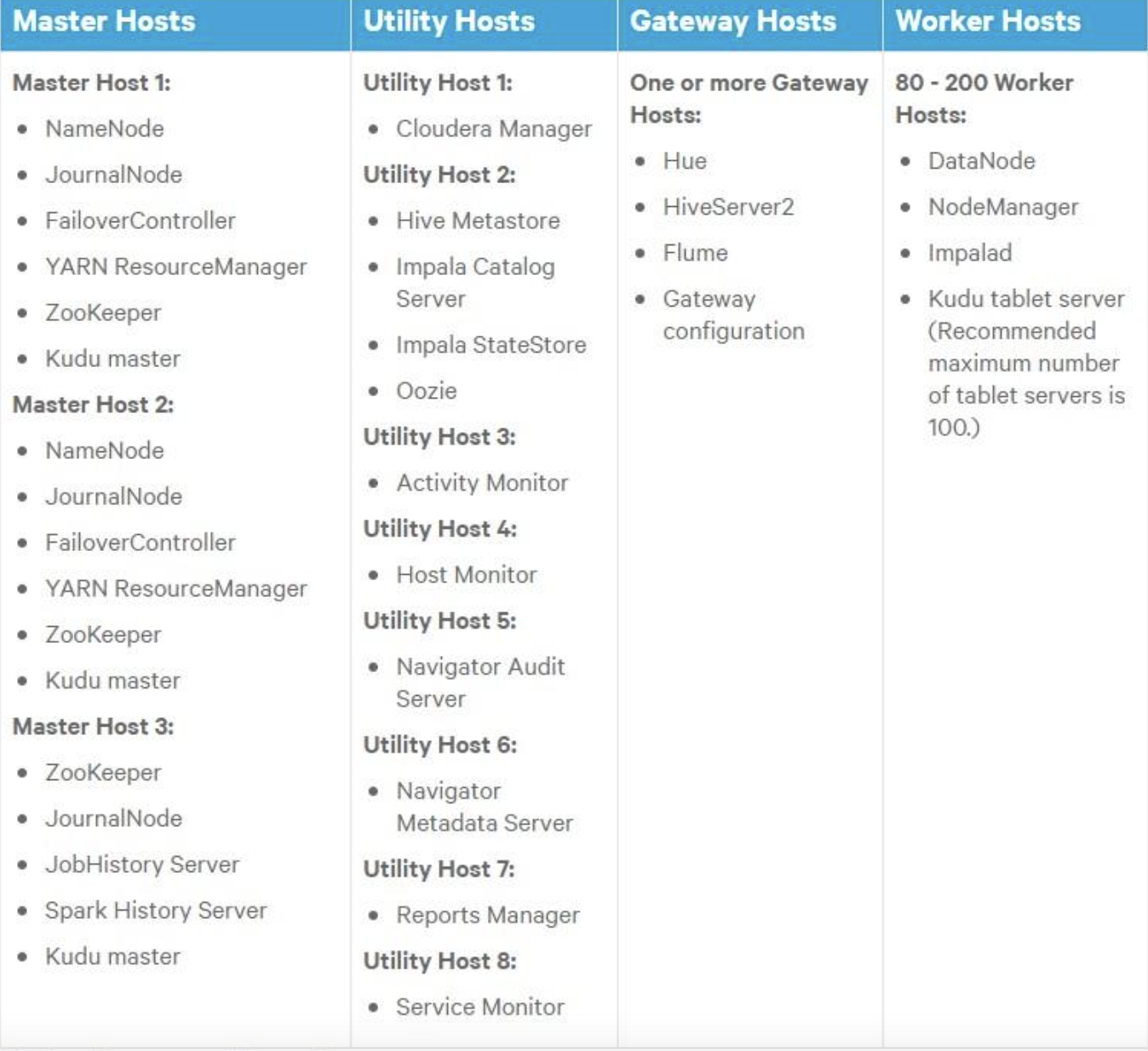

CDH 官方文档有一份更详细的节点和角色配置,官网将主机分成以下四种类型:

1) Master hosts run Hadoop master processes such as the HDFS NameNode and YARN Resource Manager.

2) Utility hosts run other cluster processes that are not master processes such as Cloudera Manager and the Hive Metastore.

3) Gateway hosts are client access points for launching jobs in the cluster. The number of gateway hosts required varies depending on the type and size of the workloads.

4) Worker hosts primarily run DataNodes and other distributed processes such as Impalad.

20 - 80 Worker Hosts with High Availability

80 - 200 Worker Hosts with High Availability

华为集群定义:

1)管理节点:Management Node (MN),用于安装Manager,即集群的管理系统。FusionInsight Manager对部署在集群中的节点及服务进行集中管理。

2)控制节点:Control Node (CN),控制节点控制并监控数据节点执行存储数据、接收数据、发送 进程状态及完成控制节点的公共功能。控制节点包括HMaster、HiveServer、ResourceManager、 NameNode、JournalNode、SlapdServer等。

3)数据节点Data Node (DN),执行管理节点发出的指示,上报任务状态、存储数据,以及执行数 据节点的公共功能。数据节点包括DataNode、RegionServer、NodeManager等。

E-MapReduce集群定义

1)Master节点选型

Master节点主要部署Hadoop的Master进程。例如,NameNode和ResourceManager等。

生产集群建议打开高可用HA,E-MapReduce的HDFS、YARN、Hive和HBase等组件均已实现HA。生产集群建议在创建集群的硬件配置步骤开启高可用。如果购买时未开启高可用,在后续使用过程中无法开启高可用功能。

Master节点主要用来存储HDFS元数据和组件Log文件,属于计算密集型,对磁盘IO要求不高。HDFS元数据存储在内存中,建议根据文件数量选择16 GB以上内存空间。

2)Core节点选型

Core节点主要用来存储数据和执行计算,运行DataNode和Nodemanager。

HDFS数据量大于60 TB,建议采用本地盘实例(ECS.d1,ECS.d1NE),本地盘的磁盘容量为(CPU核数/2)*5.5TB*实例数量。例如,购买4台8核D1实例,磁盘容量为8/2*5.5*4 台=88 TB。因为HDFS采用3备份,所以本地盘实例最少购买3台,考虑到数据可靠性和磁盘损坏因素,建议最少购买4台。

HDFS数据量小于60 TB,可以考虑高效云盘和SSD云盘。

3)Task节点选型Task节点主要用来补充Core节点CPU和内存计算能力的不足,节点并不存储数 据,也不运行DataNode。您可以根据CPU和内存需求来估算实例个数。

其他称呼

1)core节点:用来运行hdfs、hive、hbase等组件实例,起到控制和调度集群的作用

2)worker节点:实际承担计算的节点,主要部署regionserver、nodemanager、datanode