大数据集群部署规划(三)节点选配方案

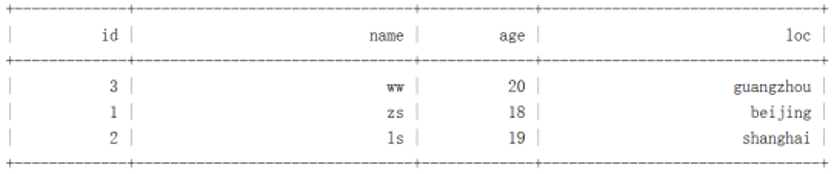

| 节点部署原则 | 适用场景 | 组网规则 | |

管理节点、控制节点和数据节点分开部署 (此方案至少需要8个节点,manager为部署商业化大数据集群时所需例如:hdp,cdh等) | core × 11 + worker × n manager × 2 (可选) | 推荐)数据节点数2000-20000时采用此方案 | 集群节点数超过200时,各节点划分到不同子网,各子网通过核心交换机三层互联,每个子网的节点数控制在200个以内,不同子网中节点数量请保持均衡。 集群节点数低于200时,各节点部署在同一子网,集群内通过汇聚交换机二层互联。 |

core × 9 + worker × n manager × 2 (可选) | (推荐)数据节点数500-2000时采用此方案 | ||

core × 5 + worker × n manager × 2 (可选) | (推荐)数据节点数100-500时采用此方案 | ||

core × 3 + worker × n manager × 2 (可选) | (推荐)数据节点数30-100时采用此方案 | ||

| 管理节点和控制节点合并部署,数据节点单独部署 | (manager+core) × 3 + worker × n | (推荐)数据节点数3-30时采用此方案 | 集群内节点部署在同一子网,集群内通过汇聚交换机二层互联。 |

管理节点、控制节点和数据节点合并部署 | 最少(manager+core+worker)x 3 |

说明: 生产环境或商用环境不推荐使用此场景:

| 集群内节点部署在同一子网,集群内通过汇聚交换机二层互联。 |