高效便捷!解锁阿里云跨账号专线互联的全新实施方案

01

背 景

02

需 求

客户的阿里云账号下,在杭州金融云可用区B内存在待迁移ECS,实例网络类型为经典网络,和线下数十家银行做经典网络专线打通。为避免业务受影响,需要重新拉专有网络专线,保证和线下银行侧能正常通信。

另外,通过调研分析发现部分银行已经通过专有网络专线和阿里云金融云网络做了内网互通,这种情况下需要考虑专线复用,以降低成本。

03

解决方案

基于目前银行侧不同的网络场景,共设计了四种网络互通方案,实现客户VPC和各个银行侧网络互通。下面分别针对这四个场景,通过图文结合的方式做详细的方案介绍,使其更便于理解。

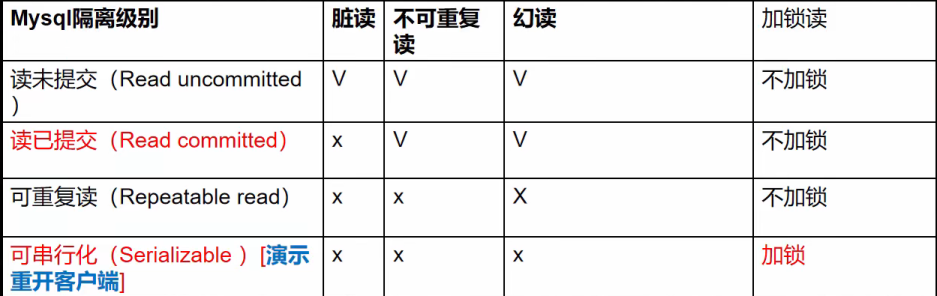

银行新拉专线,加入客户云企业网

适用场景:银行侧至客户阿里金融云 VPC 网络没有可复用的专线,并且不考虑专线冗余。

方案介绍:银行新拉1 根专线,然后借助客户金融云账号下的云企业网实现VPC和银行侧网络内网互通。

方案架构如图所示:

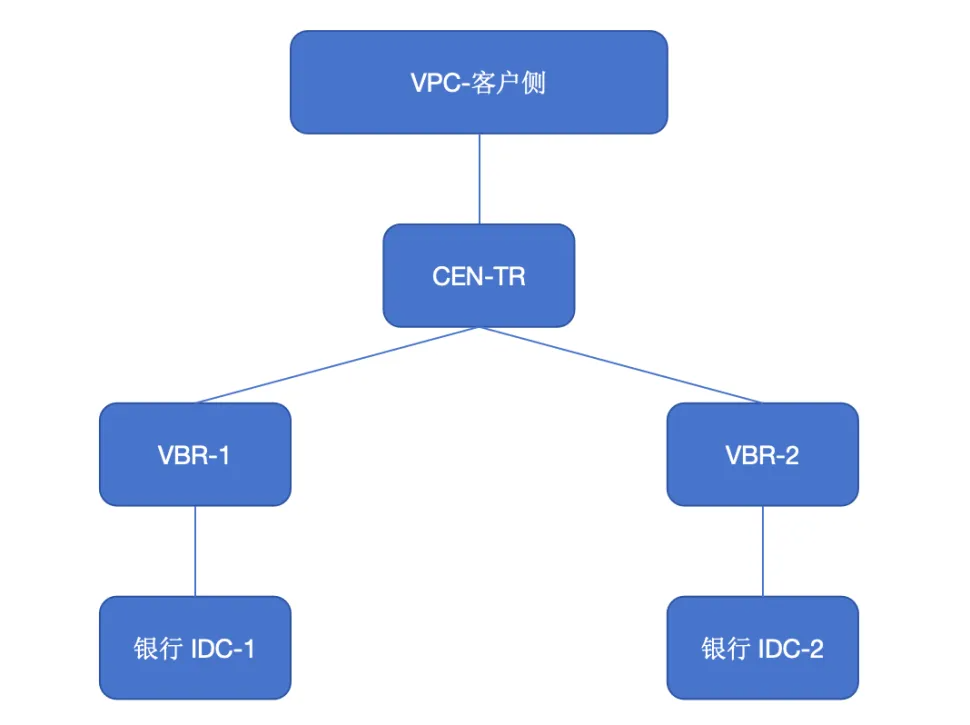

银行新拉专线,实现业务冗余

适用场景:银行侧至阿里金融云 VPC 网络没有可复用的专线,需要实现物理专线的高可用。

解决思路:银行新拉2 根专线和金融云 VPC网络互通,借助VBR上联的方式实现VPC银行侧网络内网互通,结合路由优先级以及健康检查,实现链路冗余。

方案架构如图所示:

优点:不会产生CEN-TR相关的费用。

缺点:路由无法同云企业网一样自动学习,需要手动添加

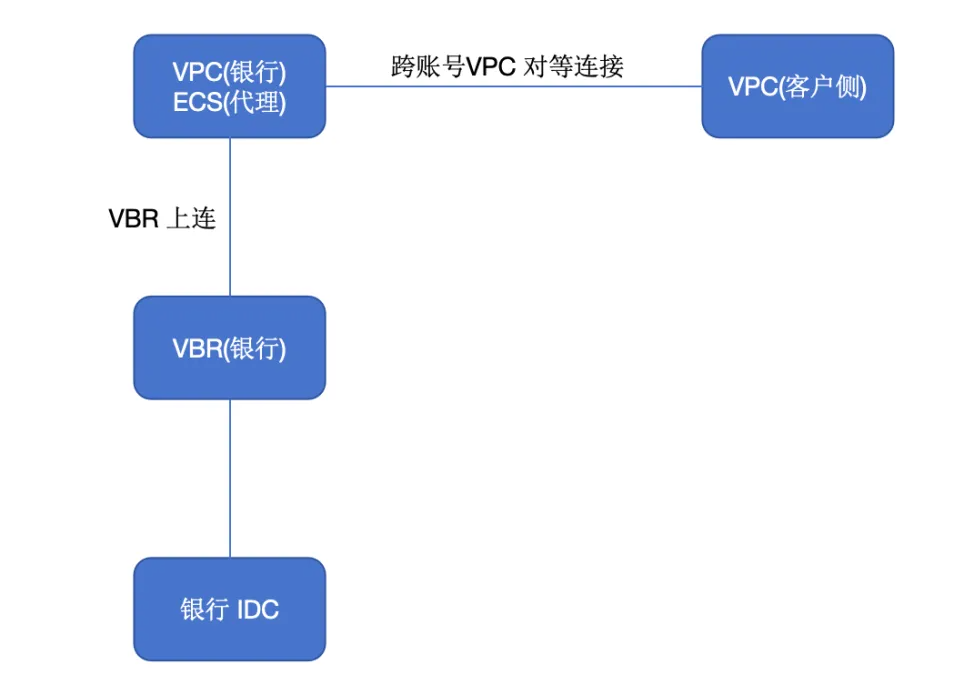

复用已有专线,创建跨账号VPC对等连接

适用场景:银行侧至银行侧金融云 VPC 网络已有可复用的专线,并且目前银行侧和银行侧 VPC是通过 VBR 上联方式做的内网打通。

解决思路:需要银行侧在 VPC 内新建一个 ECS做代理,然后将银行侧VPC和客户VPC通过VPC对等连接的方式实现内网互通。

方案架构如图所示:

创建整个VPC网段之间的对等连接,VPC内的所有资源可以通过该对等连接实现网络通信。

VPC网段重叠时,无法创建整个VPC网段之间的对等连接,此时建议根据业务情况,创建如下对等连接:

VPC子网之间的对等连接:指定子网之间网络互通,对等连接两端的子网网段不能重叠。

VPC内ECS之间的对等连接:指定ECS之间网络互通,对等连接两端的ECS的私有IP地址不能相同。

优点:不会产生CEN-TR相关的费用。

缺点:需要创建ECS做代理转发

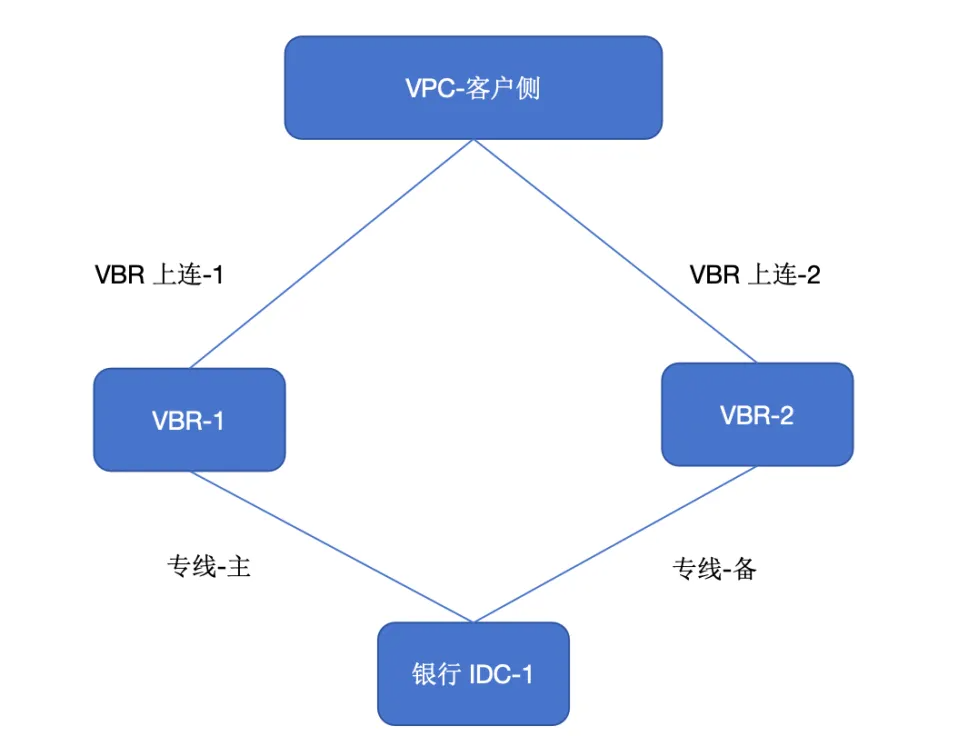

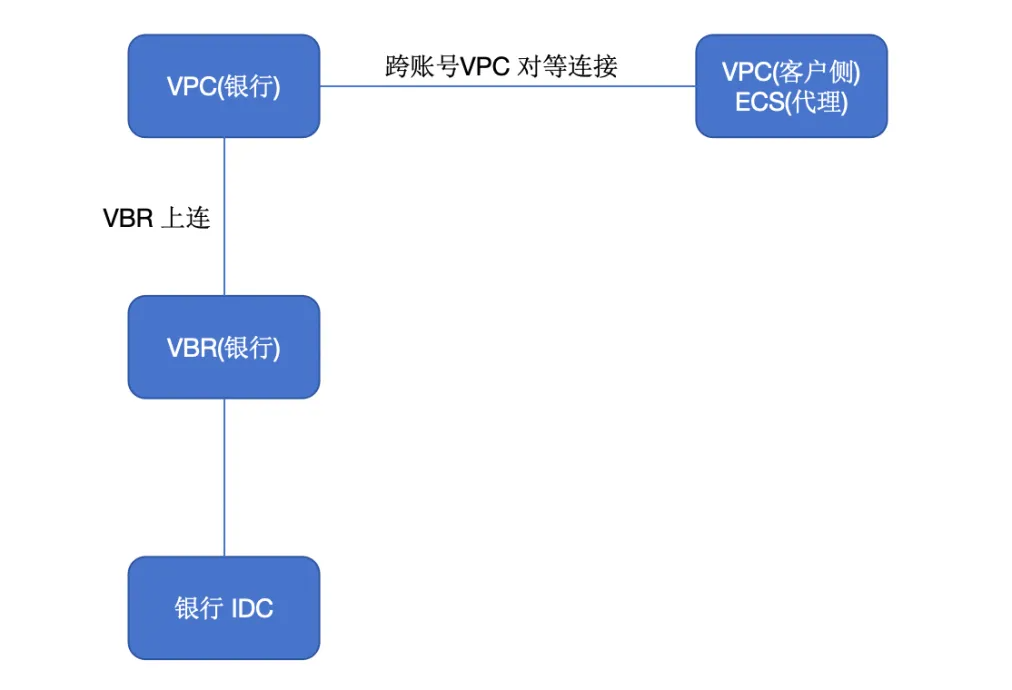

复用已有专线,跨账号加入云企业网

适用场景:银行侧至银行侧金融云 VPC 网络已有可复用的专线,并且目前银行侧和银行侧 VPC是通过云企业网方式做的内网打通。

解决思路:需要将客户VPC加入到银行侧云企业网内,最终实现银行侧和客户VPC内网互通。

方案架构如图所示:

优点:不需要创建ECS做代理转发,路由可以通过云企业网学习。

缺点:会产生CEN-TR相关的费用。

04

客户收益

在进行阿里金融云可用区基础设施架构升级与改造之前,先完成新线路网络的实施,以规避业务不可用的风险。

根据不同的场景,设计多样化的网络互通方案,以最大化满足客户需求。