Hue简介

1. Hue介绍

1.1. Hue是什么

l HUE = Hadoop User Experience

l An open source Hadoop GUI

l Web based

Hue汇聚了与大多数Apache Hadoop组件交互的接口,致力为Hadoop组件的Web图形化操作界面。Hue组件让用户轻松使用Hadoop,不用担心底层的复杂性实现,不使用命令行操作。用户可以轻松快捷的获取到结果。

1.2. Hue能干什么

l 提供HDFS文件管理操作界面

l 提供MapReduce作业管理界面

l Hive元数据管理

l Hive脚本编辑器

l Oozie工作流编辑和管理

l 提供Solr搜索界面和定制能力

l 提供Zookeeper浏览界面

l ……

1.3. Hue架构

1.4. Hue安全机制

l 浏览器与Hue之间采用HTTPS协议,防止消息拦截。

l 支持单点登录,Hue与Manager使用同样账号(Manager上创建的所有人机账号都可以登录Hue)。

l Hue与Hadoop组件之间采用Kerberos认证。

1.5. Hue支持哪些组件

HDFS、HBase、S3

Hive、Impala、Presto、Trino、Flink、Phoenix、Druid、Spark

Solr、ES、ClickHouse

Spark、Yarn、Ooize、Knox

Oracle、PG、DB2、Vertica、MYSQL

2. Hue应用举例

从文件中创建一个表

说明

本例演示从本地上传一个文件,然后根据文件创建Hive表并导入数据。

数据准备

下面为某公司员工工资数据,将其保存为文件(salary.txt)

CustNo,Gender,Department,Age,Salary

0001,男,开发部,30,10000

0002,男,开发部,28,19000

0003,男,开发部,30,10500

0004,女,开发部,33,12000

0005,男,开发部,27,9000

0006,男,开发部,35,18000

0007,女,市场部,30,11000

0008,男,市场部,29,24500

0009,女,市场部,38,30500

0010,男,市场部,45,12600

0011,男,市场部,28,9700

0012,男,市场部,35,18000

0013,女,公共部,24,5000

0014,女,公共部,25,45000

0015,男,公共部,25,6500

0016,女,公共部,30,18000

0017,女,公共部,23,4000

0018,女,公共部,25,45000

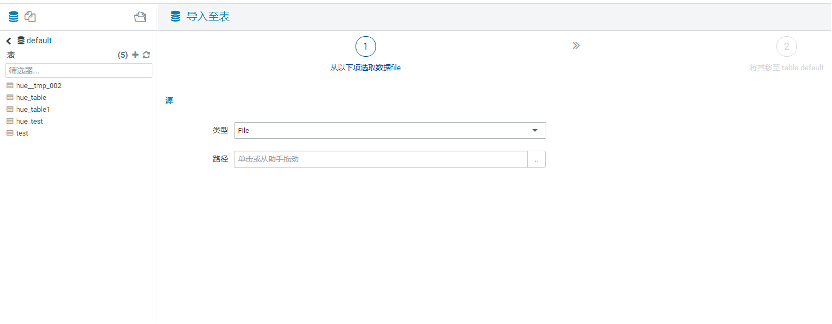

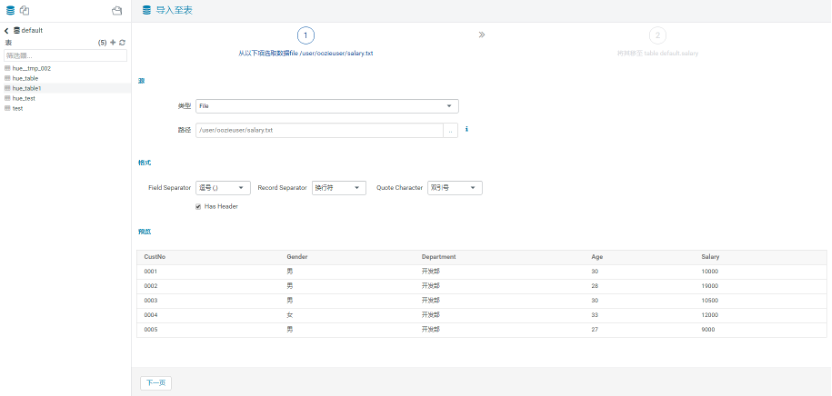

l 步骤一:

a、从Hue菜单上选择“表”,单击右边“新建”。

b、“类型”选择File。

c、单击..,然后单击“上传文件”,从本地选择文件salary.txt上传到hdfs路径下。

D、单击“下一页”。

l 步骤二:

a、Hue显示上传的文件内容,自动识别为一个电子表格。

b、单击“下一页”。

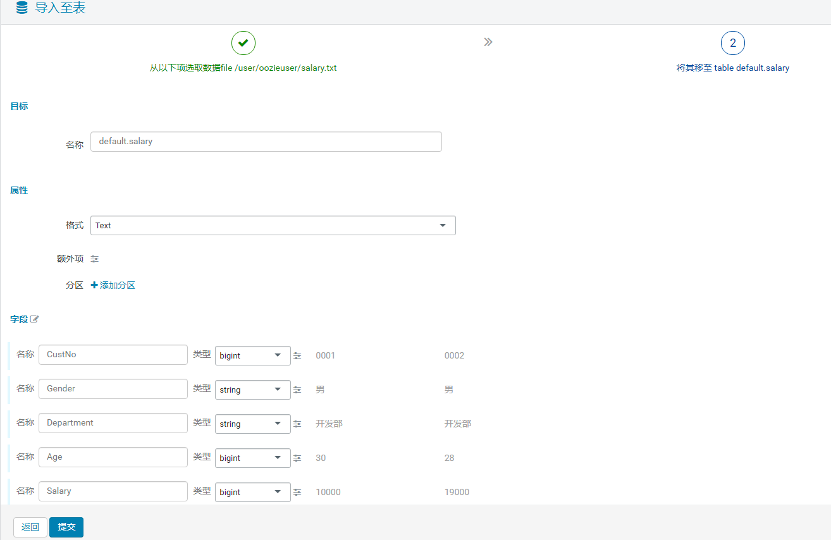

l 步骤三:

a、“目标”区域下的“名称”为表名称。如果需要,需要用户手动修改。

b、Hue自动识别字段名和类型,如果不正确,需要用户手动修改。

c、单击“提交”。

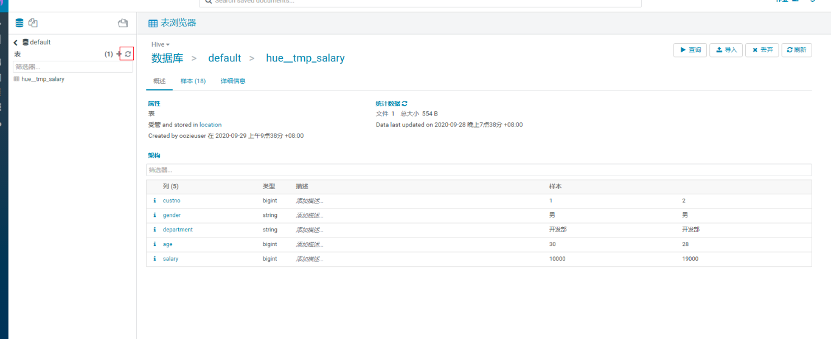

l 步骤四:

点击左侧导航按钮,右侧显示salary表定义。