ES运维(八)添加IK分词器

一、概述

ES自带standard analyzer、simple analyzer、whitespace analyzer、stop analyzer、language analyzer、pattern analyzer等6种分词器。这里介绍ik分词器集成(es版本为7.12.1)

二、集成IK分词器

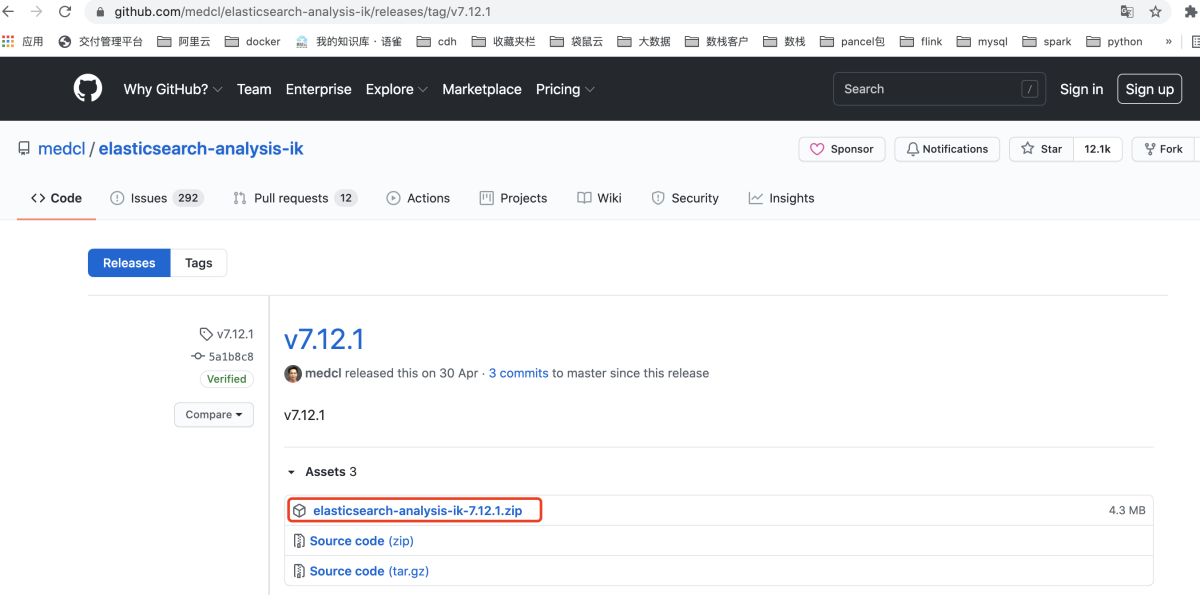

1、下载分词器包

下载地址: https://github.com/medcl/elasticsearch-analysis-ik/releases/download/v7.12.1/elasticsearch-analysis-ik-7.12.1.zip

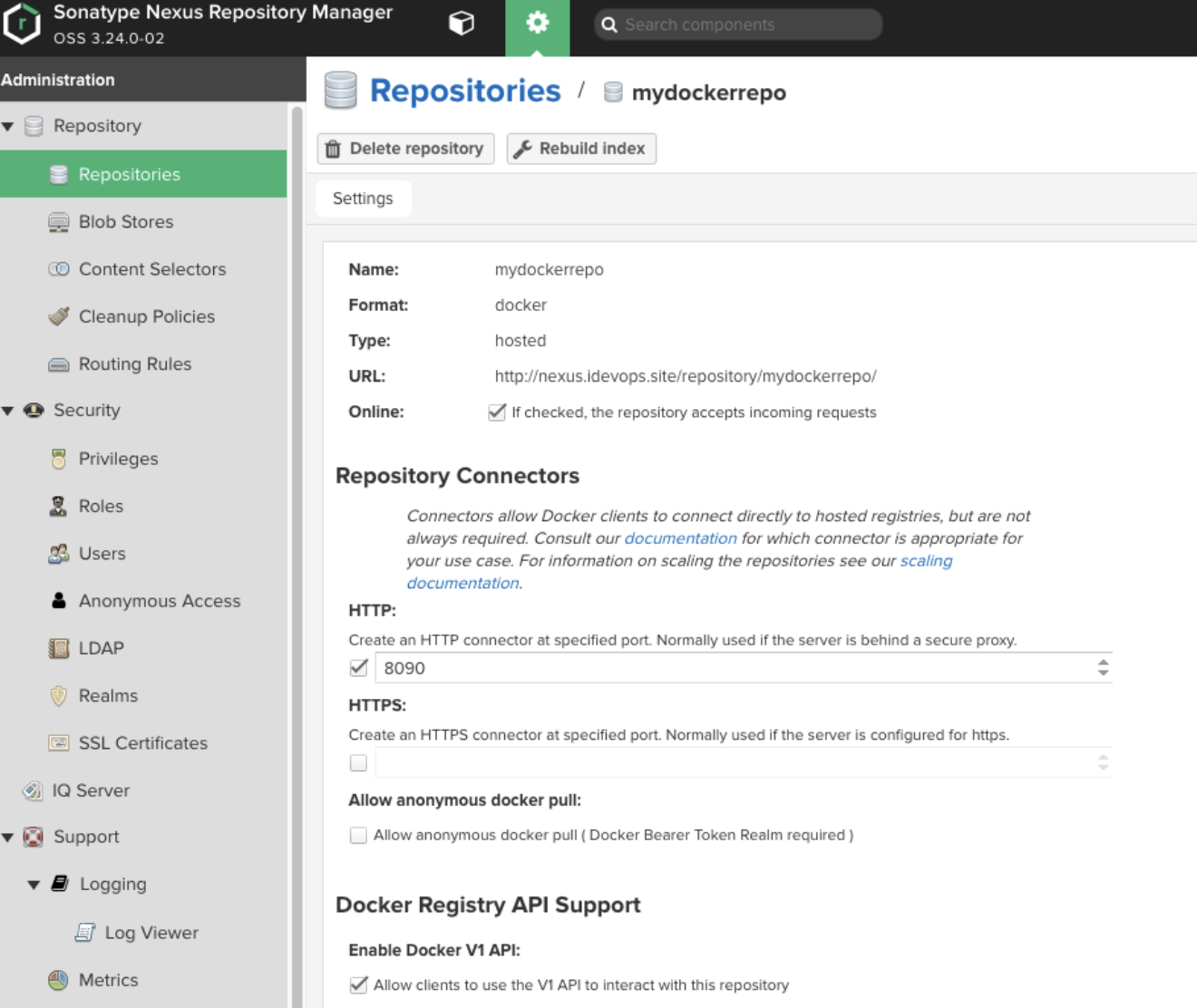

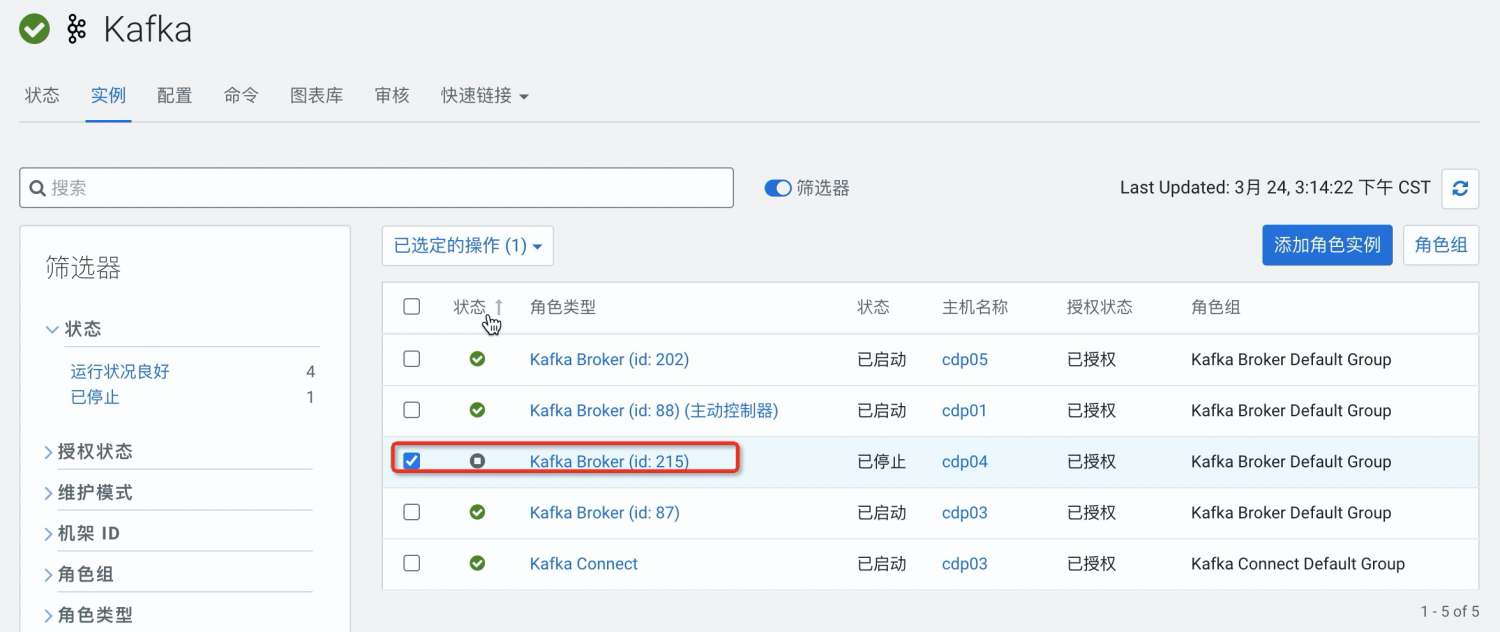

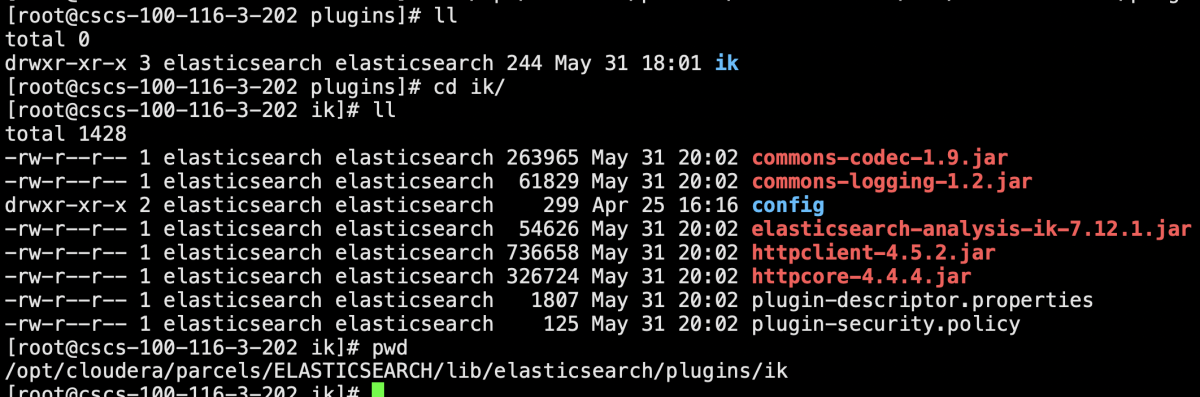

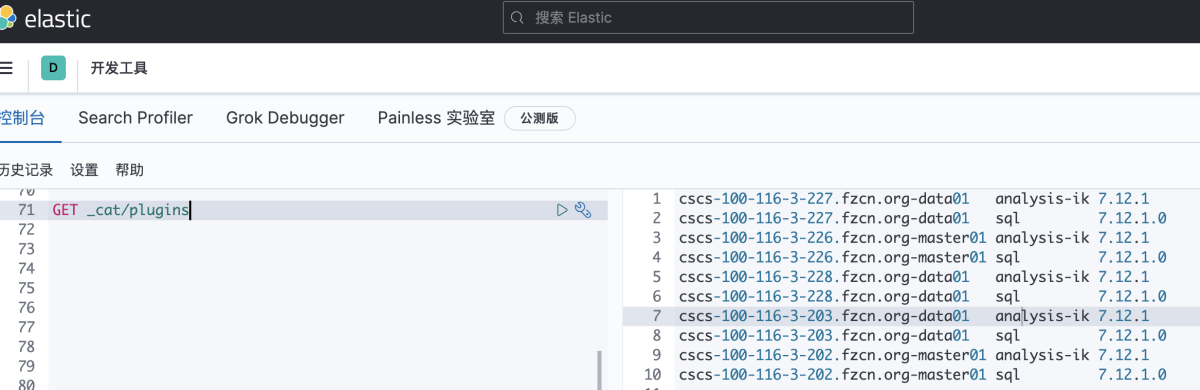

2、分发插件

所有es节点均要上传: /opt/cloudera/parcels/ELASTICSEARCH/lib/elasticsearch/plugins/ 分发后重启es集群

三、使用ik分词器

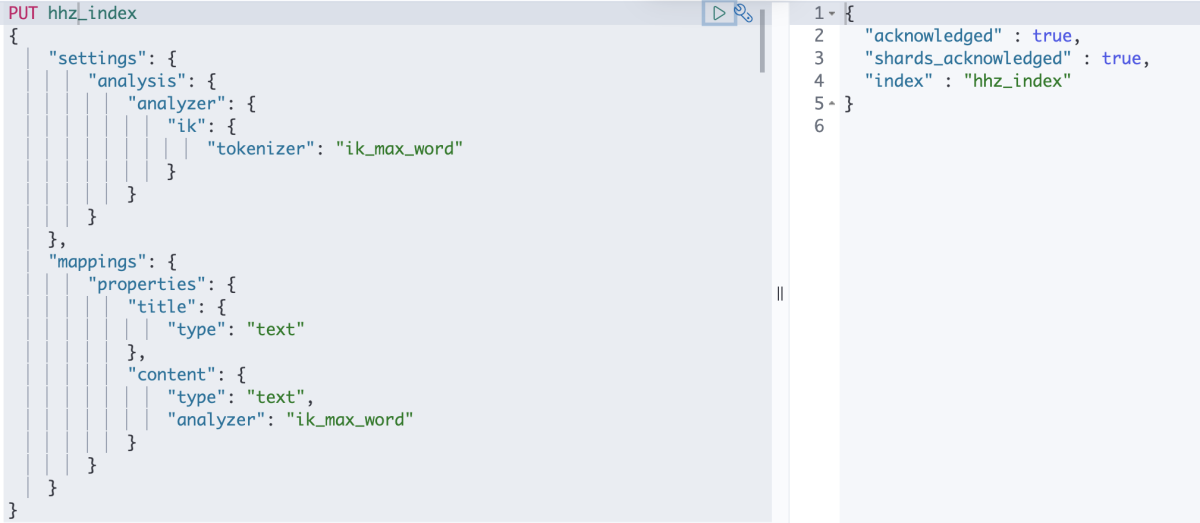

1、创建索引并指导分词器

PUT hhz_index

{

"settings": {

"analysis": {

"analyzer": {

"ik": {

"tokenizer": "ik_max_word"

}

}

}

},

"mappings": {

"properties": {

"title": {

"type": "text"

},

"content": {

"type": "text",

"analyzer": "ik_max_word"

}

}

}

}

2、使用ik分词器

POST _analyze

{

"analyzer": "ik_smart",

"text": ["我是河南人"]

}

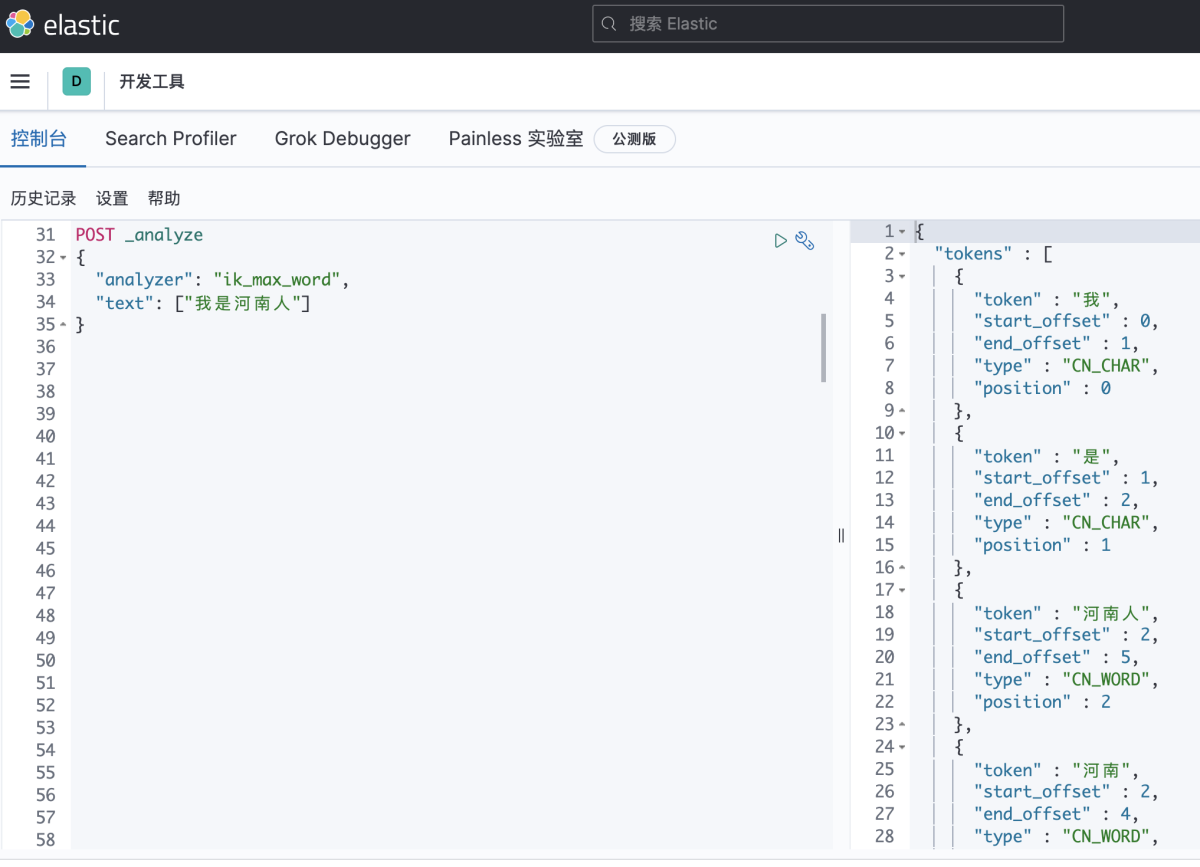

3、将文本做细粒度拆分

POST _analyze

{

"analyzer": "ik_max_word",

"text": ["我是河南人"]

}