harbor数据迁移-SOP

背景

线下自建harbor需要迁移至云上自建harbor

迁移方案

harbor私有仓库的主从复制实现数据迁移

前置条件

harbor目标仓库已部署好,并且版本和源仓库版本最好保持一致

迁移步骤

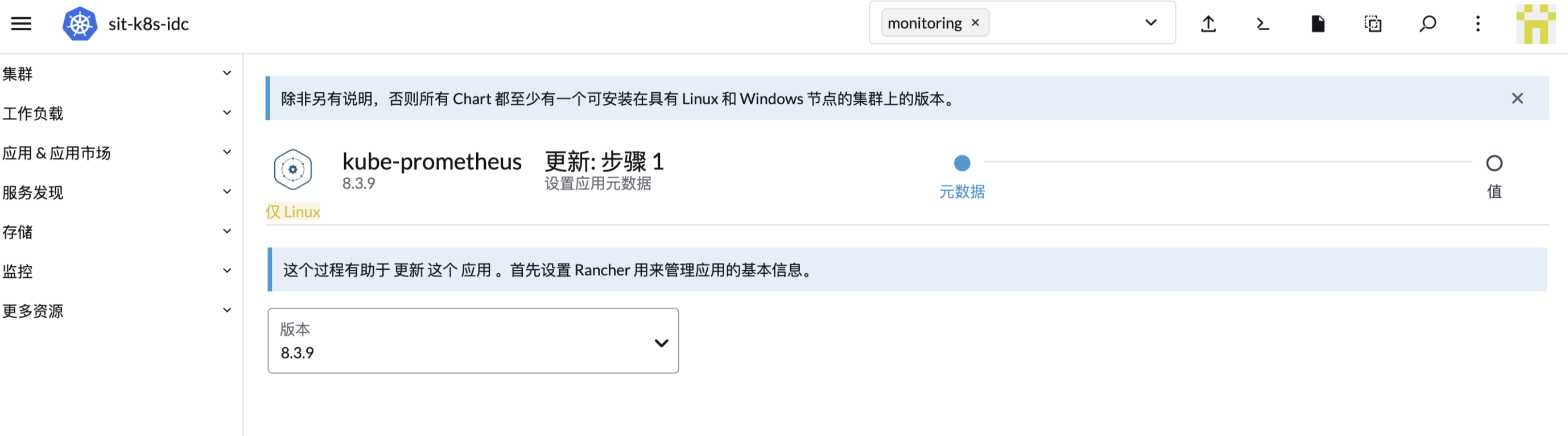

1、配置slave仓库连接信息

harbor master仓库配置,将slave仓库连接信息按要求填入

📌注意:如果远程实例使用的是自签或者非信任证书,不要勾选“验证远程证书”

2、配置复制规则

配置过滤规则,选择目标slave仓库。触发模式支持:自动、手动以及定时三种方式,按需配置即可。其中,如果slave仓库不存在源库信息,会自动创建。

3、验证

通过历史复制任务执行详情,可以看到任务复制内容

登陆slave节点harbor,查看目标镜像复制成功。