CDH实操--客户端安装

概述

安装CDH客户端,主要是方便在CDH部署节点以外,通过客户端的方式连接CDH上的hdfs,hive和hbase服务

1、安装jdk(适配CDH即可,一般1.8)

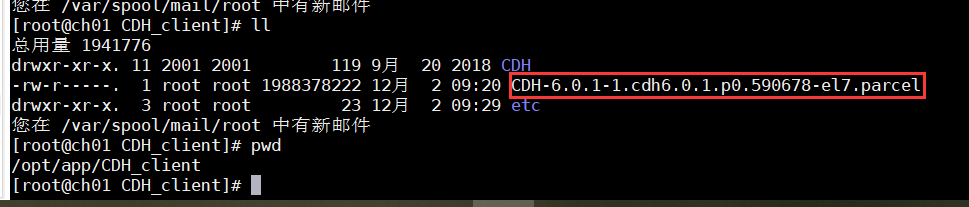

2、获取安装包

3、部署安装包

把安装包解压即可:

mkdir /opt/CDH_client

mkdir /opt/CDH_client/etc

tar xvf CDH-6.0.1-1.cdh6.0.1.p0.590678-el7.parcel

mv CDH-6.0.1-1.cdh6.0.1.p0.590678 CDH

4、配置客户端

A、从hadoop获取hive配置文件

a、 在Cloudera Manager管理界面中,选择Hive服务

b、 在“操作”菜单中选择“下载客户端配置文件”

c、 将配置文件上传Hadoop客户端/opt/CDH_client/etc目录,文件名为hive.zip

d、unzip /opt/CDH_client/etc/hive.zip

B、从hadoop获取hbase配置文件(CDH03为hadoop集群一个节点)

a、scp -r root@CDH03:/etc/hbase /etc/

C、配置客户端节点hosts文件

a、将CDH集群的hosts映射拷贝到客户端节点即可

D、修改客户端环境变量,将以下命令追加到/etc/profile里,确保每个用户都有同样一套环境变量

export JAVA_HOME="/usr/java/jdk1.8.0_181-cloudera"

export HADOOP_HOME="/opt/app/CDH_client/CDH"

export HIVE_HOME="/opt/app/CDH_client/CDH/lib/hive"

export HBASE_HOME="/opt/app/CDH_client/CDH/lib/hbase"

export HCAT_HOME="/opt/app/CDH_client/CDH"

export HADOOP_CONF_DIR="/opt/app/CDH_client/etc/hive-conf"

export HIVE_CONF="/opt/app/CDH_client/etc/hive-conf/"

export YARN_CONF_DIR="/opt/app/CDH_client/etc/hive-conf"

export CDH_MR2_HOME=$HADOOP_HOME/lib/hadoop-mapreduce

export PATH=${JAVA_HOME}/bin:${HADOOP_CONF_DIR}:${HADOOP_HOME}/bin:${HADOOP_HOME}/sbin:${HBASE_HOME}/bin:${HIVE_HOME}/bin:${HCAT_HOME}/bin:${PATH}

注释:为了减少侵入性,也可以将此环境变量添加到一个普通文件,每次登陆时手动source一下就行

5、连通性验证

a.验证HDFS

hadoop fs –ls / #如果可以列出目录,证明HDFS客户端配置成功;

b.验证HIVE

beeline -u "jdbc:hive2://CDH01:10000/default;principal=kylin/slave4@MCITP.COM" #如果是基于kerberos登录,使用这种方式;

beeline -u "jdbc:hive2://CDH01:10000/default" #如果是基本认证登录,则采用这种方式

show databases;#如果可以进入beeline命令行模式,而且可以显示默认数据库defaul,证明beeline客户端配置成功。

c.验证HBASE

hbase shell

list #如果可以进入hbase shell,并且可以列出hbase中的表名,证明hbase客户端配置成功